La física, como ciencia experimental que es, está basada en las relaciones entre observables físicos y medidas instrumentales. Estas relaciones se expresan mediante leyes físicas que plasman en lenguaje físico-matemático los invariantes observados experimentalmente.

Al tratarse de una ciencia positiva los invariantes serán siempre relativos, es decir, refutables en futuros experimentos. El lenguaje de la física sintetiza los conocimientos de las estructuras estables de la dinámica física universal, que son explicados mediante leyes físicas con una estructura matemática que permanece invariante frente a ciertas transformaciones matemáticas. Este es el punto de vista de la física clásica.

El lenguaje de la física clásica en el siglo XX

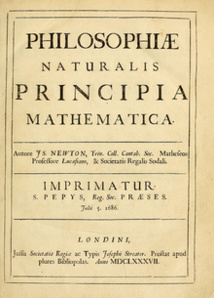

La epistemológica de la ciencia ha evolucionado hacia una idea relativista del orden físico. Si bien Newton habla en sus Principia [1] de un espacio y tiempo absolutos como sensorio de Dios, tanto él como Galileo conciben un universo físico donde no existe un centro espacial distinguido, ni una reseña temporal característica. Con sus estudios de la naturaleza, Galileo y Newton condujeron a la ciencia física hacia un terreno relativista sin sistemas de referencia especiales donde las leyes físicas son las mismas con independencia de rotaciones en el sistema de referencia, de acuerdo con la dinámica newtoniana.

Newton ponía la confianza en un Dios relojero que ajusta la mecánica celeste para que el cosmos no decayera en un caos planetario debido a las pequeñas descompensaciones en las fuerzas gravitatorias. Su cosmología personal difiere mucho de la cosmología actual fundada en los modelos cosmológicos acerca de un universo dinámico en continua evolución, pero su idea del dinamismo cósmico estacionario influiría en la cosmología de Einstein, el personaje más influyente del XX.

La física ha ido incorporando del lenguaje matemático una serie de transformaciones que han configurado geométricamente la cosmovisión física moderna. Desde tiempos de Galileo se estudió las transformaciones de coordenadas entre dos observadores en movimiento relativo que describen el movimiento de un mismo cuerpo. Con la teoría electromagnética de Maxwell, fue necesario establecer nuevas transformaciones cuando las velocidades se acercaban al límite clásico de la velocidad de la luz.

Estas nuevas transformaciones, denominadas transformaciones de Lorentz, suponen una nueva interpretación geométrica de la gravedad y del espacio-tiempo. La idea de espacio y tiempo es muy diferente para Newton y su física fundada en las transformaciones de Galileo, que para Einstein, cuya ley de gravedad fundamenta sus modelos cosmológicos espaciotemporales.

El lenguaje de la física del siglo XX es el resultado de la formalización físico-matemática de la revolución epistemológica iniciada en la modernidad. Se mantiene la idea de una ley como principio rector del orden físico, pero los fundamentos físicos se difieren a la interpretación geométrica de un lenguaje matemático más técnico.

Este aparato matemático no es experimental en sí mismo, sino que proyecta leyes físico-matemáticas, que sí pueden someterse a la experimentación. Sin embargo, la estructura matemática subyacente no es física en sí misma y, por tanto, no ofrece conclusiones metafísicas.

De este modo, el lenguaje de la física se desliga cada vez más de lo ontológico y se nutre, casi exclusivamente, de un andamiaje matemático de marcado corte idealista. Se va anticipando una tendencia que no hará sino calar profundamente en la comunidad científica de los físicos del XXI hasta, incluso, llegar a afirmar que toda la realidad física es, en última instancia, pura información. Sin una definición experimental de información, sin más que un lenguaje matemático que no distingue entre información y probabilidad, parece lógico caer en un idealismo formal [2].

De las transformaciones de coordenadas a la geometría del universo

En la física aristotélica existe una concepción absoluta del espacio descrita por la geometría de Euclides [3]. Todos los puntos del espacio físico mantienen su identidad con el paso del tiempo como los puntos de un espacio euclidiano de tres dimensiones (E3). Según Aristóteles, el mundo es eterno; por tanto, no existe un instante de tiempo privilegiado, digamos un tiempo cero. Consecuentemente, el tiempo aristotélico es un espacio infinito unidimensional euclidiano (E1).

Desde el lenguaje de la física-matemática, podemos pensar que la estructura del mundo aristotélico, es una correspondencia entre espacio (E3) y tiempo (E1); es decir, un espacio-tiempo absoluto (E3xE1) donde es posible diferenciar las distancias espaciales y los intervalos temporales, pues espacio y tiempo son realidades independientes.

En el siglo XVI, Galileo estableció el principio de invariancia de las leyes físicas frente a cambios de sistemas de referencia inerciales, es decir, sistemas sin aceleración. De acuerdo con este principio, las leyes de la física permanecen inalterables con independencia de la velocidad del sistema de referencia no acelerado. Galileo ya había descubierto que el estado de movimiento de un cuerpo descrito por dos observadores inerciales (x,X) es el mismo si se toman en cuentan unas transformaciones de las coordenadas de los sistemas de referencia (x=X+Vt).

Las transformaciones de Galileo ligan las posiciones de un cuerpo observadas por dos observadores que se mueven relativamente a velocidad constante (V) y, por tanto, perciben velocidades diferentes para un tercer móvil que se observe desde uno (vx) o desde el otro (vX). Básicamente, estas transformaciones de referencia mantienen la ley de la suma de velocidades (vx=vX +V) y postulan que el tiempo medido por cada observador es el mismo (t=T).

Se trata, pues, de una concepción clásica del espacio y del tiempo como magnitudes absolutas independientes, donde no es posible diferenciar el movimiento del reposo absoluto. En realidad es imposible decidir si X se mueve y x está parado, o viceversa, pues sólo los movimiento relativos son físicamente detectables.

El principio de invariancia de Galileo exige una transformación del espacio-tiempo aristotélico. En el espacio-tiempo de Aristóteles no hay criterio para afirmar o negar que un punto del espacio ocupado por una partícula, sea el mismo en otro instante. Sin embargo, de acuerdo con la física de Galileo, carece de sentido afirmar absolutamente que una partícula permanece en un mismo punto del espacio durante un cierto intervalo de tiempo; puesto que no es posible diferenciar si está en reposo o en movimiento absoluto.

En consecuencia, el lenguaje de la física debe ser invariante ante la posibilidad de movimiento absoluto. No es posible afirmar o negar que la partícula ocupe el mismo punto del espacio en términos absolutos. Pero el espacio absoluto es irrelevante en el lenguaje de la física, porque las transformaciones de Galileo exigen que la física no dependa de estas cuestiones metafísicas.

La física no puede distinguir el estatus ontológico de la partícula referido a un sistema absoluto; simplemente, es invariante ante transformaciones de sistemas de referencia relativos. En el mejor de los casos, el lenguaje físico-matemático queda a ras de un desconocido fondo ontológico.

Como es imposible mantener una relación entre las posiciones espaciales de una partícula en dos instantes de tiempo, se requiere ampliar el lenguaje físico-matemático con una nueva geometría que describa un espacio-tiempo provisto de la invariancia de Galileo. Para ello, se necesita una nueva estructura geométrica denominada fibrado, que asocia a cada instante de tiempo de (E1) todo un espacio (E3) distinto.

De esta manera se pierde la identificación entre los puntos del espacio de un instante a otro, aunque la estructura sigue gozando de cierta unidad matemática, que permite el movimiento o reposo relativos de una partícula a través de infinidad de espacios (E3) a lo largo de un tiempo absoluto (E1). Con el principio de invariancia, Galileo destierra parte del lenguaje metafísico del campo de acción de las ciencias físicas.

Su estudio, sin embargo, es limitado; pues, sólo trata de movimientos uniformes. Al incluir las aceleraciones de los movimientos, será necesario introducir nuevos elementos geométricos que modifican la estructura geométrica del universo físico [4].

Sabemos que la electrodinámica clásica de Maxwell impulsó la física tanto a nivel técnico (ondas de radio) como conceptual (campos de luz). Sin embargo, la formalización matemática clásica del electromagnetismo es representante también de un hito teórico que reorienta el lenguaje de la física en sus versiones clásica decimonónica y cuántica contemporánea.

La velocidad de propagación de los campos electromagnéticos resulta de la teoría de Maxwell como una constante absoluta que tan sólo depende de las propiedades electromagnéticas del medio y, por tanto, es independiente del estado de movimiento del observador.

Es decir, las leyes del electromagnetismo no dependen del sistema inercial de referencia, en perfecto acuerdo con el principio de invariancia de Galileo. Ahora bien, la ley de suma de velocidades de Galileo ya no se cumple, pues todo observador debe medir la misma velocidad de la luz, independientemente de su estado de movimiento.

El carácter absoluto de la velocidad de la luz exige introducir un nuevo principio de invariancia para que, con independencia de la velocidad del sistema de referencia, todo observador mida invariantemente la misma velocidad de propagación lumínica (c). La constancia de la velocidad de la luz dota al espacio-tiempo de una estructura fundamental que afecta tanto al espacio como al tiempo.

La teoría de la relatividad especial de Einstein (1905) incluye el principio de invariancia de Galileo y lo generaliza para preservar la constancia de la velocidad lumínica. De esta manera, las leyes de cambio de las coordenadas de dos observadores inerciales siguen las transformaciones espaciotemporales de Lorentz.

Estas son las nuevas transformaciones que preservan la invariancia relativista de la velocidad de la luz. A bajas velocidades las transformaciones relativistas se reducen a la clásica suma de velocidades. Por este motivo las sorprendentes consecuencias de la Relatividad no se perciben en los sucesos cotidianos. Se recupera así la invariancia clásica y la estructura del espacio-tiempo se asemeja al espacio y tiempo de Galileo.

Como consecuencia de esta estructura lorentziana que preserva la invariancia de la velocidad de la luz, espacio y tiempo dejan de ser magnitudes absolutas independientes. La magnitud de referencia es ahora el espacio-tiempo. Los intervalos temporales entre dos sucesos, así como las distancias que los separan son magnitudes relativas al sistema de referencia. Conceptos clásicos como la distancia, duración o simultaneidad pierden su carácter absoluto.

Las leyes de la física, independientes del estado metafísico de reposo o movimiento uniforme, no distinguen cuestiones acerca de la permanencia ontológica del lugar (principio de invariancia de Galileo) ni entre el espacio y el tiempo absolutos (principio de relatividad de Einstein). El lenguaje de la física relativista no habla ya de espacio y tiempo en el sentido epistemológico de Newton, sino de reglas y relojes con longitudes y ritmos en dependencia directa con el movimiento relativo del observador. Es más, la invariancia Lorentz sitúa en pie de igualdad a todos los puntos del fibrado y, por tanto, las cuestiones metafísicas se hacen más indistinguibles aún.

La constancia de la velocidad de la luz estructura el espacio-tiempo de tal manera que se asocia un cono de luz a cada punto del fibrado. La luz se propaga en trayectorias tangentes a cada cono de luz y cualquier otra partícula se desplaza por el interior de estos conos. Así, no todos los puntos del fibrado pueden formar parte de la misma trayectoria y la estructura de conos de luz permite hablar del principio de causalidad física que establece una relación causal pasado-futuro entre algunos sucesos del espacio-tiempo.

Dos sucesos en conexión causal están separados por un intervalo temporal y dos sucesos sin conexión causal lo están por un intervalo espacial. En general, para cualesquiera dos sucesos en conexión causal existe al menos un observador que los ve en el mismo espacio. Y para cualesquiera dos sucesos en conexión temporal existe al menos un observador que los ve simultáneamente. De donde se sigue que un mismo suceso está en el futuro para un observador, mientras que el otro ya lo recuerda como pasado. Ni espacio ni tiempo son absolutos.

Con la publicación de los Principia en 1687 se presenta el principio fundamental de la dinámica, que permite distinguir entre movimientos rectilíneos uniformes y movimientos acelerados. En ausencia de fuerzas (caso galileano) la partícula describe una trayectoria recta con velocidad constante como indica el primer principio de Newton, el principio de inercia.

Cuando aparecen fuerzas, las partículas ya no están obligadas a describir trayectorias rectilíneas, pudiendo trazar una mayor variedad de caminos; se dice entonces, que las partículas sufren aceleraciones. Newton distingue entre fuerza viva (vis viva), la inercia o energía cinética de un cuerpo en movimiento uniforme y vis impressa como agente del cambio de velocidad en un movimiento. Ante tal diversidad de trayectorias (con y sin aceleración) se necesita introducir un elemento geométrico distintivo en física relativista: la derivada covariante o conexión.

A diferencia de los objetos físicos de la mecánica clásica y su dinámica newtoniana, en la teoría de Einstein aparecen sucesos y procesos que surgen y transcurren en el espacio-tiempo. Según la teoría de la relatividad, existe una relación de semejanza entre sucesos-procesos y ciertas cantidades invariantes bajo ciertas transformaciones. Las leyes de la física deben tener la misma forma en cada sistema de referencia.

Este postulado, el principio de relatividad, es una propuesta heurística que no ha encontrado refutación experimental alguna. En este marco, las partículas no pueden considerarse como puntos de partida para el razonamiento del mundo físico. Más bien, son abstracciones de una única totalidad indivisible en continuo dinamismo: el espacio-tiempo donde se producen la síntesis de partículas en un orden físico explícito, a partir de la condensación del campo de energía implicada.

Se trata de una entidad formada por sucesos espaciotemporales conectados localmente; es decir, que los acontecimientos en una región de espacio-tiempo sólo afectan a otra región distante una vez ha transcurrido el tiempo suficiente para que la última sea afectada causalmente por la primera. Así, pues, el lenguaje de la física relativista presupone la continuidad, el determinismo y la localidad.

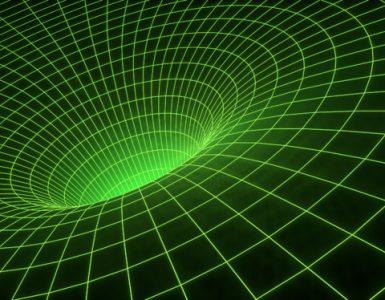

El principio de equivalencia de Einstein (1907), incluido en su teoría de la relatividad general, establece que no es posible distinguir si una fuerza constante es consecuencia de una interacción gravitatoria o de un estado de aceleración. De esta manera no es posible distinguir entre una caída libre en un campo gravitatorio y una trayectoria acelerada cualquiera. Por tanto, se puede pensar que la caída libre en un campo gravitatorio equivale a un movimiento natural por un espacio-tiempo curvo cuya curvatura produce la aceleración del sistema.

En consecuencia, no es posible distinguir como Newton entre movimientos inerciales y acelerados. Por el principio de equivalencia no hay manera local de distinguir un campo de gravedad o una aceleración. Es más, la caída libre en un campo de gravedad es experimentada como un movimiento inercial por el observador que cae. El principio de equivalencia exige una nueva estructura que generalice la noción de movimiento inercial: la conexión.

La conexión estructura el espacio-tiempo y permite discriminar entre geodésicas, trayectorias rectilíneas en un espacio dado, de cualesquiera otras trayectorias aceleradas definidas por una cierta curvatura. La gran intuición de Einstein fue ver la equivalencia entre movimientos acelerados y las geodésicas en espacio-tiempo curvos.

La física relativista proporciona una imagen de la geometría del mundo físico basada en las transformaciones matemáticas de las coordenadas entre sistemas de referencia inerciales, así como en la equivalencia de sistemas inerciales y sistemas en caída libre. Cuanto más usa la física el lenguaje matemático, tanto más prescinde de las cuestiones metafísicas para dar cuenta de fenómenos físicos como el carácter absoluto de la velocidad de la luz. Aún así nos ofrece una concepción ontológico-geométrica del mundo. Nos dice cómo debe ser la ontología geométrica del mundo físico para que acontezcan los fenómenos físicos observados.

Puede haber quien opte por continuar pensando una metafísica racional al margen de la física. La alternativa es pensar una metafísica coherente con las teorías físicas que permitan entender cuestiones metafísicas con futuras implicaciones físicas. Nos referimos a pensamientos metafísicos construidos desde las teorías físicas que permitan explicar cuestiones puramente metafísicas como el origen del tiempo o qué condiciones ontológicas son necesarias para que emerja el orden de las estructuras físicas complejas.

De la física relativista al modelo cosmológico del Big Bang

La cosmología clásica griega se basaba en una concepción circular del tiempo pautada por los eternos movimientos circulares de las esferas celestes. Con su teoría de la relatividad Einstein refutó la idea de un tiempo cósmico absoluto. No existe un río del tiempo absoluto. En el lenguaje de la física relativista los conceptos ahora, antes y después pierden su significado clásico y carecen de la validez universal para ordenar instantes de tiempos en una secuencia lineal. No existe un río temporal ni circular (concepción griega) ni lineal (concepción cristiana).

En física relativista parece que el tiempo es simétrico y no fluye [5]. Sin embargo sí se acepta cierto dinamismo, pues las partículas se entienden como concentraciones locales de energía en el espacio-tiempo. De igual manera la geometría de nuestro universo es especial y acepta un tiempo cosmológico coordinado, es decir, una referencia temporal universal que fundamenta fechar el origen de la actividad física del un universo en un Big Bang acontecido hace trece mil quinientos millones de años [6].

Laplace estaba convencido de que la gravedad afectaba por igual a la luz que al resto de materia. De hecho, fue el primero en predecir cómo una estrella se haría invisible al convertirse en un agujero negro por interacción gravitatoria. Con las fuerzas a distancia de Newton, el campo gravitatorio diverge al infinito cuanto más se comprime un cuerpo en un punto.

De acuerdo con la teoría general de la relatividad (1915) cualquier tipo de energía es una fuente gravitatoria. Con este presupuesto y el dinamismo geométrico del espacio-tiempo la relatividad de Einstein ofrece una explicación de la gravedad prescindiendo de fuerzas a distancia. Además, la nueva teoría de la gravedad da cuenta de fenómenos inexplicables por la física newtoniana como son los agujeros negros, la rotación de las órbitas planetarias, las ondas gravitatorias y los efectos gravitatorios sobre la luz: curvatura de los haces de luz y su variación de frecuencia en presencia de gravedad [7].

Durante las tres primeras décadas del siglo XX, cuajó la idea de un universo eterno. Cualquier comienzo físico en el tiempo suponía una singularidad temporal inaceptable. Desde 1917 la teoría de la relatividad de Einstein se aplica a los modelos cosmológicos. Fiel a su época y a la regularidad del cosmos, Einstein propuso un primer modelo estático del universo.

El tiempo no fluye y consecuentemente el cosmos es eterno. Para ello, introdujo un término en sus ecuaciones de campo que dependía de una constante cosmológica. El valor de la constante cosmológica se fijaba para que el universo fuese estático en el tiempo. Sin embargo, este modelo presentaba una característica desconocida por el mismo Einstein: se trataba de un modelo inestable que, ante pequeñas perturbaciones produciría una expansión o una contracción.

En 1919, gracias a las observaciones de Hubble con el telescopio de Monte Wilson, se descubrió que cada parte del Universo está separándose de cualquier otra con una velocidad proporcional a la distancia entre ambas. El espacio-tiempo se está deformando de tal manera que produce la expansión del Universo.

Poco después, en 1922, Friedmann y Lemaître encontraron independientemente soluciones dinámicas a las ecuaciones de campo y Einstein no tardó en reconocer su error. Posteriormente, Robertson y Walker formularon el primer modelo cosmológico dinámico con simetría temporal.

De acuerdo con las observaciones el universo físico es homogéneo e isótropo a gran escala; es decir, no existen direcciones ni lugares privilegiados. Por tanto, carece de sentido hablar de un centro del Universo a partir del que se produce la expansión; pues desde cualquier observación se llega a la falsa percepción de ocupar un lugar privilegiado. Fue Lemaître quien postuló que el universo emergió en un gigantesco destello radiativo, en un Big Bang usando el lenguaje irónico de Hoyle que, junto a Bondi y Gold, defendían aún un modelo cosmológico estacionario.

La teoría del Big Bang no ofrece una explicación de cómo llegó a existir. Los cosmólogos habían evitado el problema de la creación. Tampoco valía pensar que había sido creado de la nada o a partir de una singularidad inicial, pues son términos carentes de significado físico. Tryon en 1973 propuso que el universo es una fluctuación a gran escala de la energía del vacío. En sus propias palabras: el universo es simplemente una de esas cosas que ocurre de tiempo en tiempo. Veneziano y Penrose han postulado algunas teorías sobre el antes del Big Bang [8].

Del orden determinista clásico al nacimiento de los sistemas complejos

La teoría cinética de los gases, desarrollada –entre otros– por Dalton, Gay-Lussac, Avogadro, Boltzmann y Maxwell, es otra de las teorías físicas decimonónicas cuyos resultados cuestionaban el determinismo de la mecánica clásica. Las propiedades macroscópicas de la materia gaseosa (presión, energía, temperatura…) eran explicadas estadísticamente con independencia de las condiciones físicas precisas de cada partícula individual.

Debido al orden caótico de las moléculas de un gas, cualquier pequeño cambio en las propiedades físicas de una partícula (su posición o velocidad) altera el conjunto del orden microscópico sin repercutir en el macroscópico. Parece ser que, la insensibilidad de las magnitudes macroscópicas a cambios microscópicos se debe a la cancelación de los efectos individuales a gran escala.

Las fluctuaciones microscópicas se cancelan y aparecen agregados macroscópicos cuyas propiedades termodinámicas son correctamente descritas estadísticamente. Había nacido la mecánica estadística, cuyas predicciones físicas eran más precisas cuanto más partículas constituían el sistema.

La revolución industrial auspició el nacimiento de la termodinámica, que explicaba todo el conocimiento ingenieril de la industria con el lenguaje de la física clásica. Carnot, hijo del ministro de la guerra del gobierno de Napoleón, trabajó para aumentar el rendimiento de los motores de vapor. Se sumergió en los principios de la conversión de calor (energía) en trabajo mecánico y su reversibilidad. Es posible elevar la temperatura de un fluido agitándolo, pero no hay manera de recuperar la energía mecánica invertida a partir del calor generado.

Se percató de que sin la presencia de un foco frío, el calor es un tipo de energía inútil que no produce resultados mecánicos. Debe de existir un gradiente de temperatura que ponga a fluir el calor. Clausius completó la investigación de Carnot, formalizando la primera y la segunda ley de la termodinámica. Es imposible convertir enteramente calor en trabajo, pues algo de energía se corrompe siempre en la transformación. Una vez que la energía se disipa en calor, no realiza trabajo. Decimos que la energía se ha degradado.

La noción de fluctuación estadística no encajaba bien en el lenguaje de la mecánica clásica, pues no existía una correspondencia con una entidad material objetiva. Sin embargo, hoy sabemos que dichas fluctuaciones termodinámicas existen en ciertos contextos físicos y pueden ser predichas estadísticamente con buena precisión experimental. La temperatura de un sistema físico está bien determinada a partir de la noción de energía media del conjunto de partículas constituyentes.

Predicciones más precisas requieren un estudio de las fluctuaciones termodinámicas que dependen de la estructura interna de las partículas del sistema físico. La teoría cinética de los gases partía de átomos o moléculas como nivel fundamental. Cálculos más precisos deben tener en cuenta la estructura interna de dichos átomos.

Por tanto, la mecánica estadística no explica por sí misma la naturaleza de las fluctuaciones termodinámicas conectadas también a una estructura de orden más profundo como el nivel subatómico.

A finales del siglo XIX, las leyes de la naturaleza se expresaban mediante un lenguaje propio de los métodos estadísticos, que describía con buena precisión las propiedades macroscópicas de los agregados físicos. Era, pues, posible prescindir del conocimiento del par posición-velocidad de cada partícula y describir la evolución de un sistema físico en términos estadísticos. La mecánica estadística suponía la primera renuncia al estricto determinismo de Laplace, aunque mantenía la idea epistemológica de que el universo podía ser explicado mecánicamente mediante parámetros estadísticos.

Las leyes estadísticas se preciaban entonces más fundamentales que las leyes newtonianas. Sin embargo, la epistemología continuaba siendo atomística. Toda la materia en cualquiera de sus estados físicos se comprendía como distintos agregados de átomos con existencias separadas. Los constituyentes fundamentales de los cuerpos físicos seguían siendo diminutos cuerpos macizos preferentemente esféricos o partículas ideales sin extensión. Este conjunto de partículas puntuales en interacción física descrita por leyes deterministas producen la dinámica mecanicista de todo el universo.

Boltzmann profundizó en el concepto de probabilidad introducido anteriormente por Laplace y ofreció una visión no determinista del mundo microscópico capaz de explicar la realidad macroscópica. Su idea de la evolución en los sistemas termodinámicos puede sintetizarse del siguiente modo: la evolución física sigue la dirección más probable al estilo de la evolución natural propuesta por Darwin.

La genialidad de Boltzmann fue reformular la termodinámica en términos de la distribución estadística de los microestados energéticos dentro del sistema. Ante la imposibilidad –salvo para el demonio de Laplace– de calcular las trayectorias individuales de cuatrillones de partículas, es posible explicar la evolución del sistema termodinámico atendiendo a su comportamiento colectivo. Boltzmann fue capaz de salir de la esfera del determinismo corpuscular clásico e introducir en el lenguaje de la física novedosas relaciones de conceptos como: persistencia, complejidad e información [9].

El origen de la complejidad se explica por la capacidad de un sistema termodinámico para alcanzar un estado metaestable alejado del equilibrio. Estos sistemas pueden adquirir información para conseguir la energía necesaria para persistir alejados del peligroso estado de equilibrio. Los estados de equilibrio son el final más probable para el futuro de un sistema. Para un ser vivo, el estado final de equilibrio coincide con la muerte. Para el universo, el estado final predicho por la cosmología clásica se caracteriza por ser una inmensa burbuja de vacío, frío y oscuridad.

A diferencia de los sistemas aislados, condenados irreversiblemente a confundirse con su entorno, los sistemas claramente alejados del equilibrio evolucionan con mayor libertad hacia un futuro abierto que depende fuertemente de sus condiciones iniciales y de su capacidad para ganar información y energía. En otras palabras, los sistemas termodinámicos alejados del equilibrio pueden experimentar transformaciones cualitativas que originan la emergencia de nuevos niveles de realidad.

Con el desarrollo de la mecánica estadística empieza a fortalecerse la idea de que los sistemas físicos dependen solo parcialmente de la física de sus componentes a menor escala. Decimos parcialmente porque no toda la física del microcosmos se hace patente en el macrocosmos, aunque dependa estructuralmente de los soportes físicos del nivel más básico.

Consecuentemente, el concepto de niveles de realidad comienza a integrarse en el lenguaje de la física. Así las propiedades físicas de los sistemas complejos como los gases se pueden entender como la consecuencia estructural emergente de la interacción de múltiples componentes de un nivel estructural microscópico cuya física produce un nuevo nivel de realidad que no se reduce a la física del macrocosmos.

El lenguaje de la física clásica produce una imagen física de la realidad basada en la asunción de la reversibilidad temporal y el determinismo causal. El propio Newton admitía que la naturaleza es simple, reversible y determinista. Sin embargo los experimentos físicos del siglo XX han evidenciado que las partículas elementales han resultado ser casi todas inestables y distan mucho de servir del soporte permanente de las apariencias cambiantes.

En la misma línea, la cosmología contemporánea describe la evolución del universo como el despliegue irreversible de estructuras cada vez más complejas [10]. La física se reafirma, pues, en su búsqueda de conocimiento por los terrenos del indeterminismo, la no-linealidad, la no-localidad, la complejidad y el caos.

Igualmente, la termodinámica de no-equilibrio ofrece un lenguaje emergentista que asume la posibilidad de expresar distintos niveles físicos de realidad, en función de su energía y complejidad. Tendremos oportunidad, al hablar en otro artículo sobre el lenguaje de la física cuántica, para ahondar en la emergencia de nuevos niveles de realidad. ¿Cómo emerge la realidad clásica del proceloso fondo cuántico de energías?

Conclusión

La manera de producir conocimiento físico ha evolucionado en el tiempo. Existe un distanciamiento ontológico en el lenguaje actual de la física, cuyo enfoque principal se proyecta hacia una excesiva formalización matemática sin una imagen física clara de la realidad. En este artículo hemos ofrecido un momento importante de la visión evolutiva de los primeros lenguajes de la física: la mecánica clásica. La imagen del universo físico en la mecánica clásica, construida dentro de ciertos sistemas formales matemáticos que permitieron crear su lenguaje propio, dio lugar a una imagen determinista, mecánica, del universo.

Sin embargo, como hemos visto, el determinismo rígido de la mecánica clásica fue puesto en cuestión por las mismas consecuencias de su evolución como manera de pensar que tuvo que enfrentarse a grandes procesos físicos (vg. masas de partículas) que exigían tratamientos estadísticos y probabilísticos. Así nació la mecánica estadística.

Nuestro objetivo, a través de diversos momentos de la historia de los lenguajes en la física, es apuntar a los perfiles de un incipiente lenguaje humanista que pudiera servir de plataforma conceptual para contribuir a la investigación de un lenguaje físico-metafísico capaz de abordar la realidad sin fisuras ni burbujas, en su conjunto.

Apuntamos a una comprensión de la ciencia física que pueda servir a la filosofía a plantearse las grandes cuestiones sobre la estructura ontológica de la realidad y sobre la Verdad final, metafísica, del universo, en cuanto podamos conocerla por la razón, por la ciencia y por la filosofía.

Las exigencias técnicas dificultan el análisis metafísico de la investigación física al tiempo que proporciona potentes vías para profundizar con precisión en la estructura ontológica de la realidad. La física cuántica desarrollada en el XX ha constatado una arquitectura fenomenológica, físico-teórica y ontológica que exige una revisión crítica de los presupuestos ontológicos clásicos. Todavía en el XXI la física cuántica sigue desplegando su alcance explicativo y ya se han iniciado las primeras tentativas que proyectan su concepción de la materia hacia otros campos tradicionalmente abordados por las ciencias humanas clásicas.

Sin duda nuestra concepción ilustrada de la realidad ha de abrirse a la luz de la física moderna y prepararse para una nueva cosmovisión de referencia que oriente el desarrollo del nuevo humanismo científico. En otros artículos de Tendencias21 de las Religiones daremos el tránsito desde la mecánica clásica a la mecánica cuántica, apuntando la forma en que la Nueva Física nos abre hoy a las grandes cuestiones sobre la ontología de la realidad y la metafísica.

Pero para hacerlo es necesario tener una idea precisa del tipo de determinismo a que dio lugar la mecánica clásica, de sus limitaciones y de lo que fue su crisis interna por el nacimiento de la mecánica estadística.

Notas:

[1] Cfr. I. NEWTON, Principios matemáticos de la filosofía natural (Alianza, Madrid, 2011).

[2] Volveremos más adelante sobre este punto en este artículo y en otros siguientes en que hablaremos del lenguaje de la mecánica cuántica.

[3] Aunque Euclides fuera un niño a la muerte de Aristóteles, éste pudo conocer la geometría euclidiana, pues parece ser que Euclides no innovó, sino que realizó un compendio de toda la geometría descubierta hasta entonces.

[4] Cfr. R. PENROSE, The road to reality. A complete guide to the laws of the universe (Knopf, New York, 2005).

[5] Cfr. I. D. NOVIKOV, The river of time. (University Press, Cambridge, 1998).

[6] Cfr. G. CHAITIN, N. da COSTA y F. A. DORIA, Gödel’s way. Exploits into an undecidable world. (CRC Press, London, 2012), p. 123.

[7] Cfr. I. D. NOVIKOV, Black holes and the universe. (University Press, Cambridge, 1990).

[8] Cfr. R. PENROSE, Cycles of time. An extraordinary new view of the universe (Bodley Head, London, 2010).

[9] Cfr. C. CERCIGNANI, Ludwig Boltzmann: The man who trusted atoms (University Press, Oxford, 2006).

[10] Cfr. I. PRIGOGINE, ¿Tan solo una ilusión? Una exploración del caos al orden. (Tusquets, Barcelona, 2004).

Artículo elaborado por Manuel Béjar Gallego, licenciado en Ciencias Físicas y Doctor en Filosofía, Universidad Pontificia Comillas (Cátedra CTR), Madrid, colaborador de Tendencias21 de las Religiones.

Hacer un comentario